Rien de nouveau dans le soleil d’Internet… à chaque innovation majeure, l’utilisation première a été détournée à des fins malveillantes, crapuleuses ou simplement illégales.

C’est le cas pour les outils de chiffrement, les réseaux anonymisant (Tor, Freenet, i2p, etc.), les logiciels Peer2Peer, les crypto-monnaies et maintenant l’Intelligence Artificielle.

Le cas Taylor Swift n’est qu’une énième illustration de cette réalité.

Les fakes porns existent depuis que les ordinateurs permettent de modifier des images. Des dizaines de sites fleurissent sur la toile pour héberger des photomontages de célébrités, et cela depuis des années.

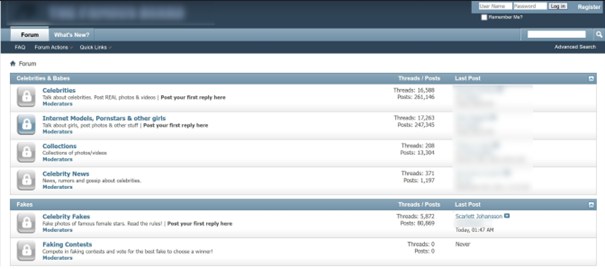

Prenons l’exemple de ce forum :

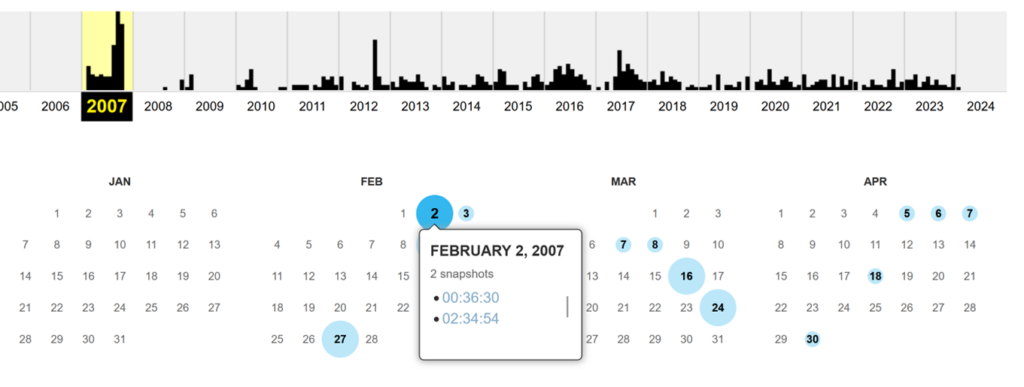

Il s’agit d’un forum spécialisé dans la diffusion d’images pornographiques ou érotiques de célébrités. La Waybackmachine l’identifie la première fois le 2 février 2007.

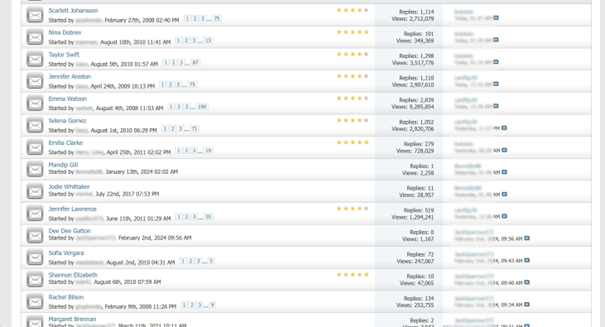

Mais le forum existe depuis presque 20 ans, le premier thread datant de septembre 2004. Le site propose une section dédiée aux fausses images et photomontages. Et la plupart des actrices médiatisées ces dernières années y ont un thread dédié.

Le thread visant Taylor Swift a été créé en 2010 et compte 87 pages. A raison de 15 à 20 photos par pages, faites le compte…

Cependant, aujourd’hui deux éléments nouveaux accélèrent ce phénomène : la généralisation des outils d’Intelligence Artificielle générative ainsi que leur facilité d’accès et d’utilisation.

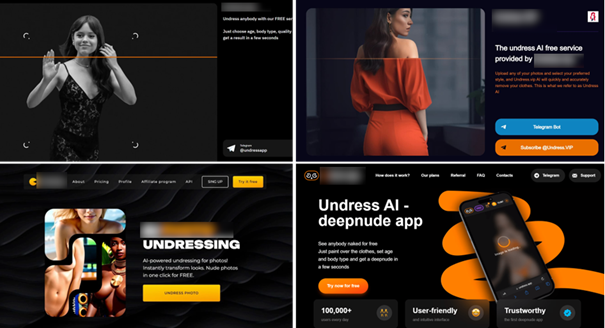

Depuis quelques mois des sites émergent sur Internet pour proposer de réaliser des photos nues à partir d’une seule photo habillée. Il suffit d’importer une photo d’une personne et vous obtenez la version nue de la photo retour.

Il y a encore quelques mois, pour modifier une image, changer un visage, incruster un décor, etc. il fallait des compétences de graphiste, savoir utiliser parfaitement Photoshop et avoir quelques heures devant soi.

Mais depuis l’émergence massive des Intelligences Artificielles génératives il suffit de télécharger une image sur un site, de rédiger quelques lignes de prompt et en 30 secondes – littéralement – on reçoit des résultats impressionnants.

Et c’est précisément là que la situation dérape. Utilisables par n’importe qui, n’importe où et facilement, ces outils sont devenus une bombe sociale. Les victimes potentielles ne se limitant évidemment pas aux célébrités et au monde du show-business.

Quels impacts ce type de contenu peut avoir pendant une période d’élection démocratique ?

Quelles conséquences dans une vie scolaire déjà ébranlée par le harcèlement en ligne ?

Quels impacts pour les carrières professionnelles ou au sein de la structure familiale des personnes visées ?

Soyons réaliste, rien n’empêchera jamais la création de faux contenus. Mais leur diffusion doit être limitée et sanctionnée. Les acteurs capables techniquement de mettre des mesures de blocage sont bien connus :

- Les réseaux sociaux qui relaient et favorisent le buzz sur ces contenus

- Les moteurs de recherche qui référencent et rendent accessibles ces contenus

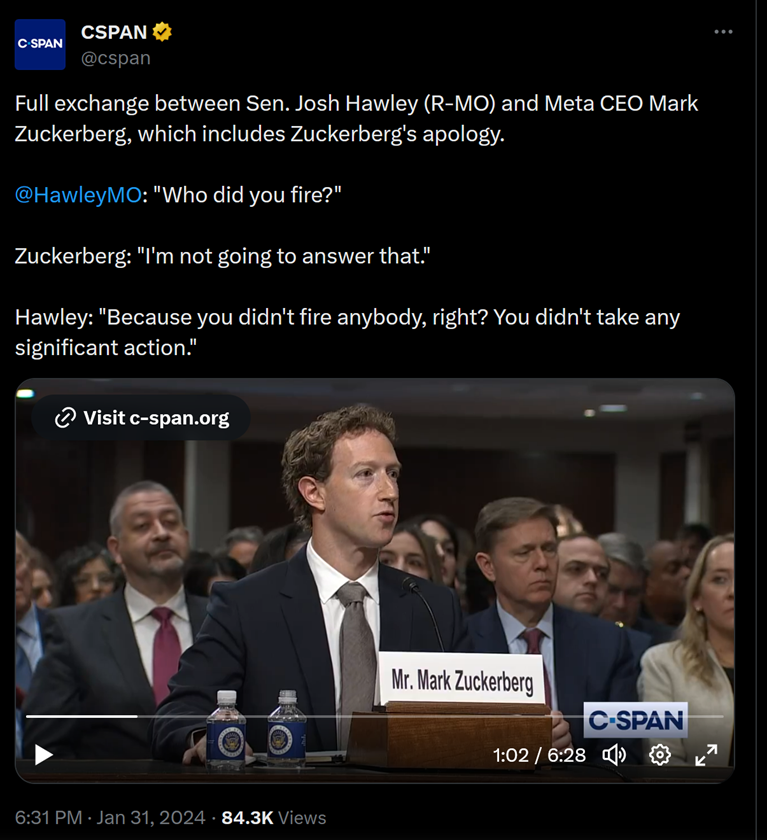

Le Congrès Américain a convoqué la semaine dernière les principaux dirigeants de réseaux sociaux pour évoquer l’exploitation sexuelle des enfants sur leur plateformes. Et si Mark Zuckerberg (Meta) s’est excusé, aucune nouvelle mesure n’a été annoncée pour contrer le phénomène pour l’instant.

L’Europe a légiféré début février sur l’usage des outils d’intelligence artificielle en votant à l’unanimité l’AI Act, listant les pratiques interdites par l’usage de l’IA. Il reste maintenant à mettre en œuvre les mesures de contrôle associées.

Le fond du problème n’est pas traité et il ne réside pas dans ce que l’on tente d’imposer, mais dans ce que l’on impose pas.

Tant que les réseaux sociaux ne seront considérés que comme des hébergeurs et non comme des éditeurs responsables de leurs contenus, et tant que les contrôles d’identités des utilisateurs de ces réseaux ne seront pas généralisés, il faut malheureusement s’attendre à d’autres affaires similaires au cas Taylor Swift.

La bienveillance sur Internet nous promet encore de belles journées ensoleillées.